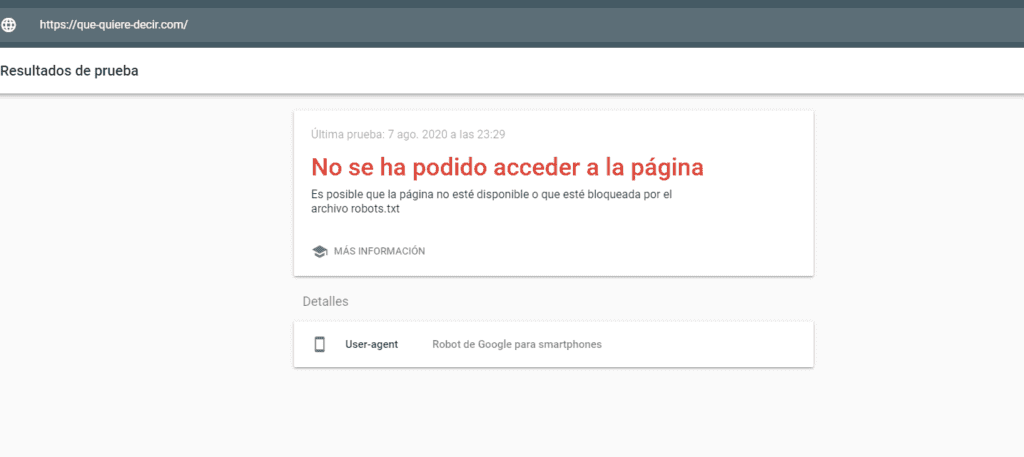

Un archivo robots txt bloquea el robot de google

generador de robots.txt

Bloquear páginas no públicas: A veces tienes páginas en tu sitio que no quieres que se indexen. Por ejemplo, puede tener una versión de una página en fase de pruebas. O una página de inicio de sesión. Estas páginas deben existir. Pero no quiere que personas al azar aterricen en ellas. Este es un caso en el que se utiliza robots.txt para bloquear estas páginas de los rastreadores y bots de los motores de búsqueda.

Evitar la indexación de recursos: El uso de meta directivas puede funcionar tan bien como el Robots.txt para evitar que las páginas sean indexadas. Sin embargo, las meta directivas no funcionan bien para los recursos multimedia, como los PDF y las imágenes. Ahí es donde entra en juego robots.txt.

Además, si tiene miles de páginas que desea bloquear, a veces es más fácil bloquear toda la sección de ese sitio con robots.txt en lugar de añadir manualmente una etiqueta noindex a cada página.

Fuera de estos tres casos extremos, recomiendo utilizar las meta directivas en lugar de robots.txt. Son más fáciles de implementar. Y hay menos posibilidades de que ocurra un desastre (como bloquear todo el sitio).

mapa del sitio robots.txt

En palabras más sencillas, un archivo de texto de robots o Robots.txt es un conjunto de instrucciones para los robots de los motores de búsqueda. Este archivo Robots.txt se añade a los archivos de origen de la mayoría de los sitios web y está pensado sobre todo para gestionar las acciones de los robots buenos, como los rastreadores web o los rastreadores de los motores de búsqueda.

Un archivo como el robots.txt es un archivo de texto sin código de marcado HTML añadido. El archivo robots.txt suele estar alojado en el servidor web como cualquier otro archivo de su sitio web. Para cualquier sitio web, el archivo robots.txt puede verse escribiendo la URL completa de la página de inicio y añadiendo después /robots.txt.

El archivo Robots.txt da instrucciones a los bots sin imponerlas. Un buen bot, como un rastreador web o un bot de noticias, intentará visitar primero el archivo robots.txt antes de entrar en cualquier otra página de un dominio y seguirá las instrucciones dadas. Por otro lado, un bot malo lo ignorará o lo procesará para encontrar las páginas web que están prohibidas.

Los archivos Robots.txt utilizan diferentes protocolos. El principal es el llamado Protocolo de Exclusión de Robots, que se utiliza para indicar a los bots qué páginas y recursos deben evitarse. En el archivo robots.txt se añaden instrucciones con formato para este tipo de protocolo.

comprobador de robots.txt

Puede haber muchas razones por las que quiera personalizar su archivo robots.txt, desde controlar el presupuesto de rastreo hasta bloquear secciones de un sitio web para que no sean rastreadas e indexadas. Exploremos ahora algunas razones para utilizar un archivo robots.txt.

Bloquear todos los rastreadores para que no accedan a su sitio no es algo que desee hacer en un sitio web activo, pero es una gran opción para un sitio web de desarrollo. Al bloquear los rastreadores ayudará a evitar que sus páginas se muestren en los motores de búsqueda, lo cual es bueno si sus páginas no están listas para ser vistas todavía.

Una de las formas más comunes y útiles de utilizar su archivo robots.txt es limitar el acceso de los robots de los motores de búsqueda a partes de su sitio web. Esto puede ayudar a maximizar su presupuesto de rastreo y evitar que las páginas no deseadas terminen en los resultados de búsqueda.

Es importante tener en cuenta que el hecho de que le haya dicho a un bot que no rastree una página, no significa que no vaya a ser indexada. Si no quiere que una página aparezca en los resultados de búsqueda, debe añadir una etiqueta meta noindex a la página.

sintaxis de robots.txt

Nota al margen. Si no define una ruta después de la directiva disallow, los motores de búsqueda la ignorarán. AllowUtilice esta directiva para permitir que los motores de búsqueda rastreen un subdirectorio o una página, incluso en un directorio no permitido. Por ejemplo, si desea evitar que los motores de búsqueda accedan a todas las entradas de su blog excepto a una, su archivo robots.txt podría tener el siguiente aspecto:User-agent: *

Continúe construyendo las directivas hasta que esté satisfecho con lo que tiene. Guarde el archivo como “robots.txt”. También puede utilizar un generador de robots.txt como éste. La ventaja de utilizar una herramienta como ésta es que minimiza los errores de sintaxis, lo cual es bueno porque un error podría provocar una catástrofe de SEO para su sitio, por lo que vale la pena pecar de precavido. Por ejemplo, para controlar el comportamiento de rastreo en domain.com, el archivo robots.txt debe estar accesible en domain.com/robots.txt.Si desea controlar el rastreo en un subdominio como blog.domain.com, el archivo robots.txt debe estar accesible en blog.domain.com/robots.txt.Prácticas recomendadas del archivo robots.txtTenga en cuenta lo siguiente para evitar los errores más comunes.Utilice una nueva línea para cada directivaCada directiva debe estar en una nueva línea. De lo contrario, confundirá a los motores de búsqueda.Mal: User-agent: * Disallow: /directorio/ Disallow: /otro-directorio/