robots txt

El archivo Robots.txt sirve para proporcionar datos valiosos a los sistemas de búsqueda que escanean la web. Antes de examinar las páginas de su sitio, los robots de búsqueda realizan una verificación de este archivo. Gracias a este procedimiento, pueden mejorar la eficacia del escaneo. De esta manera, usted ayuda a los sistemas de búsqueda a realizar primero la indexación de los datos más importantes de su sitio. Pero esto sólo es posible si ha configurado correctamente el archivo robots.txt.

Al igual que las directivas del archivo robots.txt, la instrucción noindex en la metaetiqueta robots no es más que una recomendación para los robots. Por eso no pueden garantizar que las páginas cerradas no se indexen y no se incluyan en el índice. Las garantías en este sentido están fuera de lugar. Si necesita cerrar para la indexación alguna parte de su sitio, puede utilizar una contraseña para cerrar los directorios.

¡Importante! Para que la directiva noindex sea efectiva, la página no debe estar bloqueada por un archivo robots.txt. Si la página está bloqueada por un archivo robots.txt, el rastreador nunca verá la directiva noindex, y la página puede seguir apareciendo en los resultados de búsqueda, por ejemplo si otras páginas enlazan con ella.

robots txt wordpress

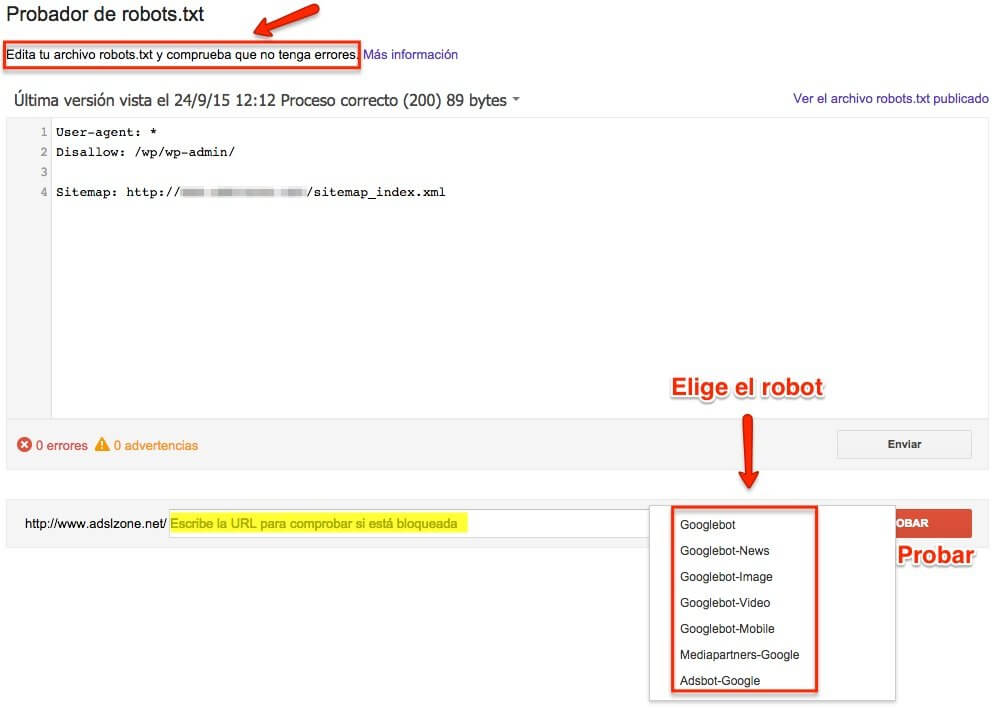

El archivo robots.txt puede crearse simplemente con un editor de texto. Cada archivo consta de dos bloques. En primer lugar, se especifica el agente de usuario al que debe aplicarse la instrucción, y a continuación sigue un comando “Disallow” tras el cual se enumeran las URL que deben excluirse del rastreo. El usuario debe comprobar siempre la corrección del archivo robots.txt antes de subirlo al directorio raíz del sitio web. Incluso el más mínimo error puede hacer que el bot no tenga en cuenta las especificaciones y posiblemente incluya páginas que no deberían aparecer en el índice del motor de búsqueda.

Esta herramienta gratuita de Ryte le permite comprobar su archivo robots.txt. Sólo tiene que introducir la URL correspondiente y seleccionar el agente de usuario correspondiente. Al hacer clic en “Iniciar prueba”, la herramienta comprueba si el rastreo de la URL indicada está permitido o no. También puede utilizar Ryte FREE para probar muchos otros factores de su sitio web. Puede analizar y optimizar hasta 100 URLs usando Ryte FREE. Simplemente haga clic aquí para obtener su cuenta GRATIS “

cómo interpretar el robots txt

El archivo Robots.txt sirve para proporcionar datos valiosos a los sistemas de búsqueda que escanean la web. Antes de examinar las páginas de su sitio, los robots de búsqueda realizan una verificación de este archivo. Gracias a este procedimiento, pueden mejorar la eficacia del escaneo. De esta manera, usted ayuda a los sistemas de búsqueda a realizar primero la indexación de los datos más importantes de su sitio. Pero esto sólo es posible si ha configurado correctamente el archivo robots.txt.

Al igual que las directivas del archivo robots.txt, la instrucción noindex en la metaetiqueta robots no es más que una recomendación para los robots. Por eso no pueden garantizar que las páginas cerradas no se indexen y no se incluyan en el índice. Las garantías en este sentido están fuera de lugar. Si necesita cerrar para la indexación alguna parte de su sitio, puede utilizar una contraseña para cerrar los directorios.

¡Importante! Para que la directiva noindex sea efectiva, la página no debe estar bloqueada por un archivo robots.txt. Si la página está bloqueada por un archivo robots.txt, el rastreador nunca verá la directiva noindex, y la página puede seguir apareciendo en los resultados de búsqueda, por ejemplo si otras páginas enlazan con ella.

agente de usuario de robots

Teniendo en cuenta tanto el Estándar de Exclusión de Robots como las extensiones específicas de las arañas, nuestro comprobador de robots.txt generará un informe fácil de leer que le ayudará a corregir cualquier error que pueda tener en su archivo robots.txt.

¿Qué es la herramienta de comprobación y validación de Robots.txt? La herramienta de comprobación de Robots.txt está diseñada para comprobar que su archivo robots.txt es preciso y no tiene errores. Robots.txt es un archivo que forma parte de su sitio web y que proporciona reglas de indexación para los robots de los motores de búsqueda, con el fin de garantizar que su sitio web sea rastreado (e indexado) correctamente y que los datos más importantes de su sitio web sean indexados en primer lugar. Esta herramienta es fácil de usar y le ofrece un informe en segundos: sólo tiene que introducir la URL completa de su sitio web, seguida de /robots.txt (por ejemplo, yourwebsite.com/robots.txt) y hacer clic en el botón “comprobar”. Nuestro comprobador de robots.txt encontrará cualquier error (como errores tipográficos, de sintaxis y de “lógica”) y le dará consejos para optimizar su archivo robots.txt.

¿Por qué debo comprobar mi archivo Robots.txt? Los problemas con su archivo robots.txt -o el hecho de no tener un archivo robots.txt- pueden tener un impacto negativo en sus resultados de SEO, su sitio web puede no clasificarse tan bien en las páginas de resultados de los motores de búsqueda (SERPs). Esto se debe al riesgo de que el contenido no relevante sea rastreado antes o en lugar del contenido importante. Comprobar el archivo antes de que su sitio web sea rastreado significa que puede evitar problemas como que todo el contenido de su sitio web sea rastreado e indexado en lugar de sólo las páginas que desea indexar. Por ejemplo, si tiene una página a la que sólo quiere que accedan los visitantes después de rellenar un formulario de suscripción, o una página de inicio de sesión para miembros, pero no la excluye en su archivo robot.txt, podría acabar siendo indexada.